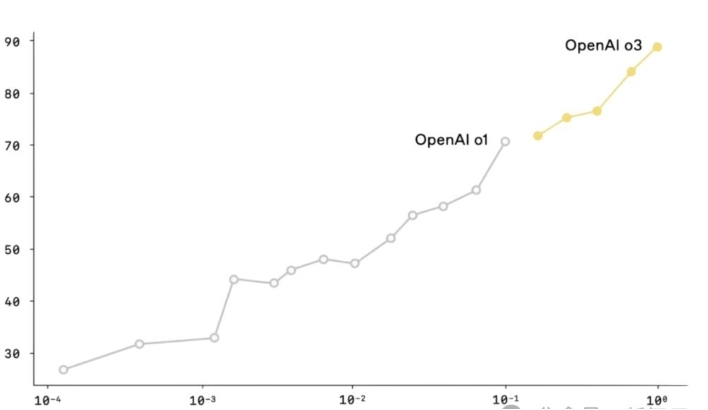

據消息,OpenAI 推出的 o3 推理模型,打破了傳統文字思維鏈的邊界 —— 多模態模型首次實現將圖像直接融入推理過程。

據介紹,它不僅 “看圖”,還能 “用圖思考”,開啟了視覺與文本推理深度融合的問題求解方式。這種 “Thinking with Images” 的能力,使 o3 在視覺推理基準測試 V* Bench 上準確率飆升至 95.7%,刷新了多模態模型的推理上限。

DeepSeek R1模型更新

不僅如此,日前,DeepSeek宣布完成R1模型小版本試升級,并邀請用戶測試官方網頁、APP及小程序功能,API接口和使用方式保持不變。

R1基于DeepSeek-V3模型能力復現,而R2可能需等待V4研發成功。新版模型平均每題使用23K tokens,較舊版12K顯著增加。英偉達CEO黃仁勛預測Agentic AI將推動算力需求暴增至少100倍。

此外,DeepSeek蒸餾出DeepSeek-R1-0528-Qwen3-8B,該8B模型在AIME 2024數學測試中表現僅次于DeepSeek-R1-0528,超越Qwen3-8B且準確率與Qwen3-235B相當。強化后訓練后,幻覺率降低45%~50%,此前R1因高幻覺率備受批評。

DeepSeek稱,此次更新通過后訓練提升了模型思維深度與推理能力,盡管工具調用等能力仍有進化空間。騰訊(TCEHY.US)迅速響應R1更新,多款產品接入DeepSeek-R1-0528。

現如今,開源與開放協議嶄露頭角,成為AI新競爭力。DeepSeek的開源成功促使行業傾向開源,OpenAI也考慮開源。眾多企業早已開啟開源戰略,同時大模型開放協議如同互聯網HTTP協議,讓大模型能便捷調用工具,完成各類任務。

微美全息開拓產業新格局

資料顯示,5G+AI視覺廠商微美全息(WIMI.US),全面加速大模型技術迭代與產業落地,圍繞大模型戰略,全面升級AI矩陣,積極采用“自研+擁抱開源”雙軌模式,重點布局多模態大模型(文本、圖像、音頻、視頻原生級融合),并計劃提供實時多模態AI模型體驗。

在行業生態上,微美全息提升多模態數據處理能力,強化商業場景應用潛力,努力加速“模型+應用”一體化,面向開發者,提供多模態交互預判需求、軟硬一體開源應用方案,有望在全感官交互、場景化記憶、分布式協同等應用領域實現進一步躍升,同時以低成本、高性能多模態模型降低開發者門檻,推動應用生態繁榮。

結尾

值得一提,有多位專業人士表示,已有研究表明,AI行業今年以來,國內外科技巨頭紛紛押注AI Agent。技術、生態、市場、政策等多方面原因,促使當前整個AI發展重心,由大模型向智能體演進。

總之,開源技術加速了行業生態發展,它不僅降低了訓練門檻,還顯著提升了泛化能力和整體性能,為開放世界的多模態智能探索提供了切實可行的新路徑。并且大模型下半場的這些趨勢,也為科技發展與行業變革指明方向,企業和開發者需緊跟趨勢,把握機遇,應對挑戰,在大模型驅動的新時代中找準定位,實現創新發展。

轉自:中國網

【版權及免責聲明】凡本網所屬版權作品,轉載時須獲得授權并注明來源“中國產業經濟信息網”,違者本網將保留追究其相關法律責任的權力。凡轉載文章及企業宣傳資訊,僅代表作者個人觀點,不代表本網觀點和立場。版權事宜請聯系:010-65363056。

延伸閱讀