概要:微軟開源BitNet模型結合芯動力RPP生態架構,可在邊緣和端側智能設備上快速適配和部署新的模型,為邊緣AI的加速普及帶來新的活力。

【內容目錄】

什么是BitNet?

BitNet的優勢何在?

國外企業在BitNet與硬件適配方面的具體實踐

國內廠商基于BitNet架構的“端側AI”模型輕量化嘗試

BitNet模型與新興具身機器人應用

BitNet有望引爆家電、汽車和手機市場

結語

一、什么是BitNet?

最近微軟發布了首個開源2B參數規模的“原生1bit”LLM -- BitNet b1.58 2B4T,從根本上重構了AI的計算引擎。它用超高效的加法運算,取代了AI模型中最昂貴的浮點乘法運算。傳統LLM(如GPT系列)依賴于高精度的16位或32位浮點數,或低精度的8位及4位整數,來表示模型中的“權重”,而BitNet則采取了一種更為激進的三元表達方法。BitNet模型中的每一個權重都只能是如下三個值之一:-1、0 或 +1,即在訓練的時候就是訓練為-1,0,1,所以在推理的時候沒有精度損失。這種設計被稱為三元量化(Ternary Quantization),因為它使用了大約1.58個比特(log 2(3)≈1.58)的信息來存儲每個權重,最終效果并不比高精度方法差。

實現這一目標的核心是其創新的BitLinear層。在標準的Transformer模型(現今大多數LLM的基礎架構)中,矩陣乘法是計算的核心和瓶頸。BitLinear層用更高效的加法和減法取代了這些昂貴的乘法運算,因為對-1、0、1的操作本質上就是加減法。重要的是,BitNet模型是從零開始就使用這種三進制方式進行訓練的,即量化感知訓練(Quantization-Aware Training, QAT),這使得模型能夠在低比特的限制下依然保持高性能,而非簡單地對已訓練好的模型進行壓縮。

二、BitNet的優勢何在?

BitNet的革命性并非空談,其優勢直指當前AI發展面臨的核心痛點:巨大的計算資源消耗和高昂的成本。其優勢表現在:

1. 極致的效率和成本效益:

內存占用大幅降低: 由于每個權重僅需約1.58位,相比于16位浮點數,BitNet可以將模型的內存占用降低約10倍。這意味著,過去需要龐大數據中心才能運行的大型模型,未來也許可以直接在個人電腦甚至智能手機上流暢運行。

計算速度顯著提升: 用加減法替代乘法,極大地簡化了計算過程。這不僅意味著更快的推理速度,也使得通過邊緣設備的CPU+NPU計算組合高效運行LLM成為可能,擺脫了對昂貴且稀缺的GPU芯片的依賴。

能耗大幅下降: 更簡單的計算和更小的模型尺寸直接帶來了能耗的顯著降低。這使得在筆記本電腦、智能汽車、物聯網設備等對功耗敏感的邊緣設備上部署強大AI成為現實,同時也響應了全球對綠色計算和可持續發展的呼吁。

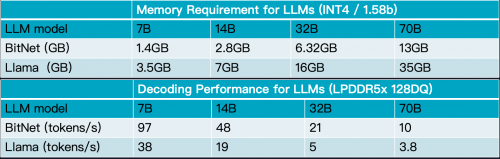

下面的圖表是BitNet與Llama大模型在存儲要求和解碼性能方面的對比。

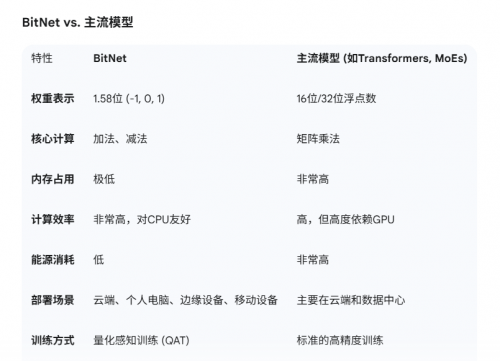

2. 保持高性能: 令人驚訝的是,這種極致的壓縮并沒有以犧牲性能為代價。微軟的研究表明,在一定模型規模(例如30億參數)以上,BitNet b1.58模型的性能(如困惑度和下游任務表現)可以媲美甚至超過同等規模的半精度(FP16)模型,這打破了“模型越大且精度越高,性能才越強”的傳統認知。下圖是BitNet與目前主流模型的參數性能對比。

可以看出,BitNet并非要完全取代Transformer架構,而是對其核心計算方式的一次“魔改”。它保留了Transformer強大的結構和能力,但通過釜底抽薪的方式解決了其效率和成本問題。

三、國外企業在BitNet與硬件適配方面的具體實踐

盡管微軟的BitNet技術在AI社區引起了不小的反響,但截至目前,國外大型電子硬件公司(如蘋果、三星、高通等)尚未公開發布任何已將BitNet直接集成到其產品中的具體實踐或合作項目。

然而,這并不意味著適配工作沒有在進行中。由于BitNet技術還非常新,相關的實踐目前更多地體現在社區驅動的實驗、性能基準測試以及為未來適配鋪路的軟件框架上。以下是當前國外企業和開發者社區在BitNet與智能硬件適配方面的主要動態:

1. 核心推動力:bitnet.cpp框架

微軟官方開源的bitnet.cpp是推動BitNet走向智能硬件的關鍵。它是一個專門為1-bit LLM設計、高度優化的推理框架。

專為CPU設計:bitnet.cpp的核心優勢在于它可以在沒有昂貴GPU的情況下,高效地在CPU上運行。這直接契合了絕大多數電子產品(如智能手機、筆記本電腦、物聯網設備)的硬件配置。

跨平臺支持:該框架支持在主流的x86架構(如英特爾、AMD處理器)和ARM架構上運行。ARM架構是幾乎所有智能手機和眾多平板電腦、邊緣設備的核心,因此bitnet.cpp的ARM優化是其在智能終端領域應用的基礎。

2. 在ARM硬件上的性能表現

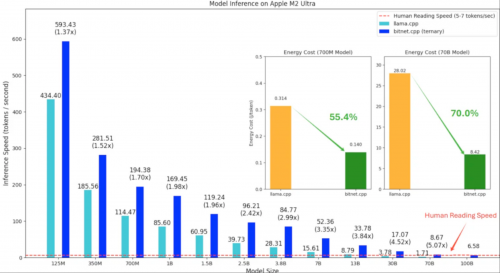

根據微軟官方測試數據,已有的基準測試展示了BitNet在常用硬件上的巨大潛力:

顯著的速度提升:在ARM CPU(如蘋果的M系列芯片)上,使用bitnet.cpp運行BitNet模型,相比于傳統的16位浮點模型(fp16),速度有1.37倍到5.07倍的提升,且模型越大,加速效果越明顯。

驚人的能效:在能耗方面,bitnet.cpp在ARM CPU上的表現同樣出色,能夠將能耗降低55%到70%。這對于依賴電池供電的移動設備來說是至關重要的優勢。

實現“不可能的任務”:測試表明,bitnet.cpp甚至可以在單個CPU上運行高達1000億參數的BitNet模型,其速度足以達到人類的正常閱讀水平(約每秒5-7個詞元)。這在過去是無法想象的,它意味著未來極其強大的AI模型或許可以直接在用戶的個人設備上本地運行。

3. 潛在的應用場景與廠商的興趣點

盡管沒有官宣合作,但可以預見,智能硬件廠商正密切關注BitNet,原因在于:

打造真正的端側AI:智能硬件廠商們(如蘋果、谷歌、三星)一直致力于將更多AI功能本地化,以提升響應速度、保護用戶隱私并降低對云服務的依賴。BitNet的輕量化和高效性使其成為實現這一目標的理想技術。

降低成本和功耗:在競爭激烈的消費電子市場,任何能夠降低硬件成本和延長電池續航的技術都極具吸引力。BitNet無需高端GPU,并能顯著降低能耗,這完美契合了廠商的需求。

催生新的智能體驗:通過在設備上本地運行強大的語言模型,可以實現更智能、更無縫的交互體驗,例如更自然的語音助手、離線的實時翻譯、設備端的文檔摘要和內容創作等。

目前,BitNet與消費電子硬件的適配尚處于“黎明前夜”。雖然我們還沒有看到支持BitNet架構的手機或筆記本電腦上市,但所有的基礎工作都在迅速推進。開發者社區和研究人員正在利用bitnet.cpp等工具,在現有的ARM和x86硬件上不斷進行測試和優化,驗證其可行性和巨大優勢。

可以預見,隨著技術的成熟和相關工具鏈的完善,未來一到兩年內,我們很有可能會看到一些領先的硬件廠商宣布與微軟合作,或推出專為運行此類1-bit模型而優化的芯片或硬件解決方案。

四、國內廠商基于BitNet架構的“端側AI”模型輕量化嘗試

雖然目前還沒有知名的國內終端廠商官宣支持BitNet,但所有頭部廠商都認識到,將AI能力從云端下放到手機、PC、汽車等邊緣和終端電子設備上,是提升用戶體驗、保護數據隱私和構建技術護城河的關鍵。

據筆者了解,邊緣AI芯片廠商芯動力是目前國內唯一在嘗試適配BitNet模型的企業。芯動力已經成功實現業界首家微軟BitNet大語言模型的本地化高效適配,其自主研發的RPP架構完美支持BitNet-b1.58-2B-4T模型推理。

在適配過程中,芯動力技術團隊采用了微軟官方推薦的I2_S編碼方式,確保模型性能的充分發揮。值得一提的是,該方案在聯想ThinkPad 16p Gen6這款革命性AI PC上展現出卓越的推理能力——作為全球首款搭載dNPU專用AI加速芯片的筆記本電腦,其內置的RPP dNPU加速卡為大型語言模型的高效運行提供了硬件級保障。

性能測試數據表明,芯動力RPP的推理效率已超越微軟官方公布的基準表現,這標志著國產AI加速技術在邊緣計算領域取得重大突破,為下一代智能終端的AI應用普及奠定了堅實基礎。

可以預見,隨著BitNet及其背后的1-bit LLM技術被證明其價值,國內廠商很可能會迅速吸收這些先進理念,并將其融入到自家的技術體系中,甚至與芯片合作伙伴共同推出專門針對此類超低比特模型進行優化的硬件,從而在這場全球性的AI效率革命中占據有利位置。

五、BitNet模型與新興具身機器人應用

BitNet模型與具身機器人的結合,代表了低功耗AI與物理智能體融合的前沿方向,下面從技術協同、應用場景、產業生態及未來挑戰四個維度來簡要分析一下其發展前景:

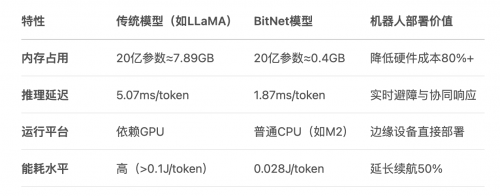

技術協同:低精度計算與機器人硬件的深度適配。BitNet的核心優勢在于超低內存資源消耗、處理器(CPU+NPU)友好性及實時響應能力,可滿足具身機器人對本地化部署、計算處理能力與能耗的最優化、物理空間的量化理解,以及動態環境的毫秒級決策等要求。

應用場景:從工業到消費領域的規模化滲透。BitNet支持輕量級端到端控制,可靈活適配AGV、裝配機械臂等工業自動化設備。在消費與服務領域,BitNet可協助小型化設備(如掃地機器人、陪護機器人)實現復雜指令理解與環境交互,解決傳統終端算力瓶頸問題。

產業生態:硬件-軟件協同創新。bitnet.cpp框架可為BitNet提供底層加速,未來可以拓展至ROS等機器人操作系統。基于Arm或RISC-V的異構計算架構(CPU+NPU)芯片,像芯動力的RPP,可以適配BitNet量化計算,極大提升能效比。

未來挑戰。BitNet依賴微軟專用框架(bitnet.cpp),尚未兼容PyTorch生態,制約開發者生態擴展。其1.58位量化方法在訓練時可能比較復雜,耗時較長,會削弱復雜場景推理能力(如多物體動態交互),需與RoboBrain 2.0等空間模型融合補償。此外,現有機器人關節模組(如滾柱絲杠、力矩電機)能耗仍高,需與AI能效提升同步優化。

未來突破路徑包括模型輕量化--擴展BitNet至多模態輸入(視覺+力控);開源生態--推動BitNet接入ROS 2.0或鴻蒙系統,吸引開發者社區;算力-執行器協同:結合諧波減速器、力矩傳感器等硬件創新,打造高能效機器人關節。

六、BitNet有望引爆家電、汽車和手機市場

當強大的AI能力可以被低成本、高效率地嵌入到每一個硬件設備中時,它不但可以降低計算成本,提升智能設備能效比,甚至將徹底顛覆現有產業的形態和價值鏈。

1. 手機產業:從“智能手機”到“AI手機”的終極躍遷

現狀: 目前的手機AI多是“偽端側”,許多功能仍需聯網調用云端API。

BitNet帶來的未來:

超級個人助理: 手機可以本地運行一個真正懂你的、擁有長期記憶的AI助理,它了解你的所有習慣和信息(因為數據不出本地),能主動為你規劃日程、管理信息、提供建議。

永不掉線的實時功能: 無論在飛機上還是地下室,實時翻譯、文檔摘要、圖像處理等功能都能瞬時完成。

極致個性化: AI可以根據你的使用習慣,實時、動態地優化手機的性能、功耗和用戶界面,成為獨一無二的“個性化手機”。

2. 汽車產業:加速邁向真正的“智能座艙”與“自動駕駛”

現狀: 智能汽車對網絡和云端算力高度依賴,自動駕駛的決策延遲和安全性是巨大挑戰。

BitNet帶來的未來:

瞬時決策的自動駕駛: 復雜的環境感知和駕駛決策模型可以在車內本地完成,擺脫網絡延遲,極大地提升自動駕駛的安全性與可靠性。

會思考的智能座艙: 車載語音助手不再是機械的“命令執行者”,而是能理解復雜語境、結合車輛狀態和外部環境進行多輪自然對話的“智能副駕”。

隱私保護: 車輛的行駛軌跡、車內對話等敏感數據都無需上傳云端,最大程度保護用戶隱私。

3. 家電產業:從“功能性產品”到“有智慧的家庭成員”

現狀: 智能家居依然停留在“手機App控制”或簡單的語音指令階段,設備間聯動生硬,并不“智能”。

BitNet帶來的未來:

主動服務的家電: 你的空調會根據你的睡眠狀態、室外天氣和你的體感習慣,主動調節到最舒適的溫度;你的冰箱能根據現有食材,主動為你生成菜譜并聯動烤箱設置程序。

無處不在的自然交互: 你不再需要尋找手機或智能音箱,可以直接對任何家電用自然語言下達指令,甚至通過一個眼神、一個手勢與之交互。

真正的智能家庭中樞: 所有家電擁有了本地的“大腦”,它們可以協同工作,形成一個統一的、無需云端協調的智能網絡,真正實現“全屋智能”。

七、結語

微軟提出的BitNet框架為邊緣AI的加速普及帶來了新的活力,也為中國企業提供了一個在AI應用領域“換道超車”的絕佳機會。智能硬件成為AI的最佳載體,而中國強大的設計制造和軟硬件整合能力,將成為AI發展的核心優勢。

類似BitNet的模型將會如雨后春筍一樣出現,而這對于硬件的靈活性要求極高,像芯動力的RPP生態架構可快速適配和部署新的模型,及時獲取生態開發者反饋并快速迭代,從而加速AI在邊緣和端側的普及。

參考資料:

1. ithome.com.tw,微軟發表首個超過20億參數的1-bit模型同樣效能但更省電、不占記憶體 - iThome

2. arxiv.org,BitNet b1.58 2B4T Technical Report - arXiv

3. arxiv.org,[2310.11453] BitNet: Scaling 1-bit Transformers for Large Language Models - arXiv

4. medium.com,Reimagining AI Efficiency: A Practical Guide to Using BitNet's 1-Bit LLM on CPUs Without Sacrificing Performance | by Kondwani Nyirenda | Medium

5. arxiv.org,BitNet: Scaling 1-bit Transformers for Large Language Models - arXiv

6. reddit.com,BitNet - Inference framework for 1-bit LLMs : r/LocalLLaMA – Reddit

7. pub.towardsai.net,Understanding 1.58-bit Large Language Models | Arun Nanda - Towards AI

8. medium.com,BitNet b1.58 2B4T: The Dawn of Ternary Intelligence | by Arman Kamran | Medium

9. pdf.dfcfw.com,端側智能行業: 人工智能重要應用,產品落地爆發在即

10. opensource.siemens.com,端側通用人工智能大模型發展趨勢及技術解析

轉自:中國網

【版權及免責聲明】凡本網所屬版權作品,轉載時須獲得授權并注明來源“中國產業經濟信息網”,違者本網將保留追究其相關法律責任的權力。凡轉載文章及企業宣傳資訊,僅代表作者個人觀點,不代表本網觀點和立場。版權事宜請聯系:010-65363056。

延伸閱讀